Pernah kepikiran nggak sih, gimana kalau perusahaan pengen adopsi LLM tapi was-was soal data privacy?

Wajar banget. Banyak perusahaan (apalagi di bidang finance, health, atau pemerintahan) yang mikir:

“Kalau request ke API publik (OpenAI, Gemini, Anthropic, dll), aman nggak data kita? Jangan-jangan kepakai buat training lagi?”

Walaupun vendor besar klaim data aman, tetap saja ada rasa nggak tenang.

Dan di sinilah Dedicated AI Cluster masuk jadi solusi. 🔐

Kenapa Dedicated AI Cluster itu menarik?

- Model jalan dedicated di cluster sendiri → resource compute bener-bener kepakai buat workload internal, bukan di-share sama orang lain.

- Data training & inference nggak keluar ke pihak ketiga. Kalau pun ada vendor infra, biasanya kontraknya sudah jelas (SLA, compliance, audit).

- Bisa fine-tune internal data tanpa takut bocor ke luar.

Intinya: perusahaan bisa punya kontrol penuh atas LLM yang dipakai.

Kalau jadi engineer perusahaan, gimana setup-nya?

Bayangin dapet task:

“Setup-in LLM internal ya. Jangan pakai OpenAI/Gemini. Harus private dan aman.”

Kira-kira langkahnya seperti ini:

1. Assessment awal

- Cari tahu dulu: butuh apa? Chatbot internal? Search engine? Knowledge base otomatis?

- Tentukan apakah butuh fine-tuning atau cukup main di prompt engineering.

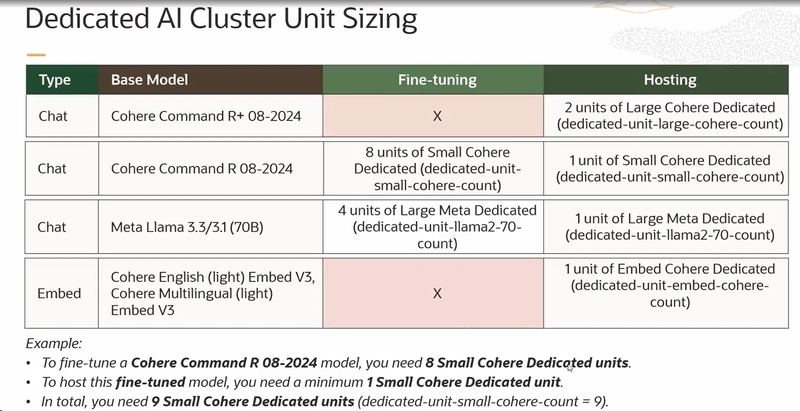

2. Pilih model base

- Kalau butuh chat general purpose → pakai Cohere Command R atau Llama 70B.

- Kalau fokus ke search/rekomendasi → pakai Cohere Embed V3.

3. Setup cluster

- Tentukan mau jalan di cloud atau on-premise (tergantung budget & regulasi).

- Misalnya pilih Cohere Command R:

- Fine-tuning butuh 8 Small Cohere Dedicated units

- Hosting butuh 1 unit

- Total = 9 units → 904 unit-hours/bulan

4. Integrasi security

- Pastikan data nggak keluar dari VPC.

- Tambahkan audit log + enkripsi (at-rest & in-transit).

5. Deploy & monitoring

- Sediakan endpoint internal API yang hanya bisa diakses lewat jaringan perusahaan.

- Tambahkan observability: logging, tracing, dan alerting (misalnya deteksi spike traffic atau overuse token).

Kenapa lebih aman dibanding OpenAI/Gemini?

- Kontrol penuh atas data & model.

- Regulasi → di industri regulated (finance, kesehatan, dll), sering ada aturan data tidak boleh keluar.

- Scalability custom → bisa disesuaikan kebutuhan bisnis, tanpa harus ikuti pricing & limit provider publik.

Jadi, kalau perusahaan mau self-hosted LLM dengan privasi ketat, arahnya memang ke Dedicated Cluster.

Bisa dibilang, ini seperti bikin “OpenAI versi internal perusahaan”.